کُندی احتمالی پیشرفت مدلهای استدلالگر هوش مصنوعی تا یک سال آینده

تحلیلی از مؤسسه پژوهشی غیرانتفاعی Epoch AI نشان میدهد که صنعت هوش مصنوعی ممکن است دیگر نتواند دستاوردهای چشمگیرتری از مدلهای استدلالگر بهدست آورد. بر اساس یافتههای این گزارش، پیشرفت مدلهای استدلالی ممکن است ظرف یک سال آینده دچار کندی شود.

مدلهای استدلالگر مانند o3 از OpenAI اخیراً موجب بهبودهای قابلتوجهی در آزمونهای سنجش عملکرد هوش مصنوعی شدهاند، بهویژه در زمینههای ریاضی و برنامهنویسی. این مدلها قادرند مسائل را با استفاده از محاسبات بیشتر تحلیل کنند و به این ترتیب عملکرد بهتری از خود نشان دهند، اما در مقابل، زمان انجام وظایف آنها بیشتر از مدلهای معمولی است.

فرایند توسعه مدلهای استدلالی معمولاً با آموزش اولیه بر دادههای عظیم آغاز میشود و سپس با استفاده از یادگیری تقویتی (Reinforcement Learning)، به مدل بازخوردهایی برای حل مسائل دشوار داده میشود.

بهگفته Epoch، تا کنون آزمایشگاههای پیشروی هوش مصنوعی مانند OpenAI مقدار زیادی از توان محاسباتی را صرف مرحله یادگیری تقویتی نکردهاند؛ اما این روند در حال تغییر است. OpenAI اعلام کرده که برای آموزش مدل o3 تقریباً ۱۰ برابر توان محاسباتی بیشتری نسبت به مدل o1 استفاده کرده و گمان میرود بخش عمدهای از این منابع صرف یادگیری تقویتی شده باشد. همچنین، یکی از پژوهشگران OpenAI به نام دن رابرتز اخیراً اعلام کرده که در برنامههای آتی، این شرکت قصد دارد یادگیری تقویتی را با اولویت بیشتری دنبال کند و حتی نسبت به مرحله آموزش اولیه، منابع محاسباتی بیشتری به آن اختصاص دهد.

با این حال، به گفته Epoch، محدودیتهایی برای افزایش توان محاسباتی در مرحله یادگیری تقویتی وجود دارد.

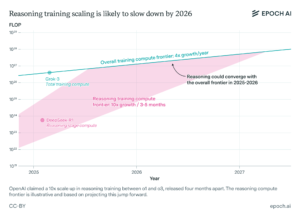

جاش یو (Josh You)، تحلیلگر Epoch و نویسنده این گزارش، توضیح میدهد که در حال حاضر دستاوردهای عملکردی مدلهای معمولی سالانه چهار برابر میشوند، در حالیکه مدلهای استدلالگر با استفاده از یادگیری تقویتی هر ۳ تا ۵ ماه ده برابر بهبود مییابند. او پیشبینی میکند که روند پیشرفت این مدلها تا سال ۲۰۲۶ به حد اشباع نزدیک خواهد شد.

گزارش Epoch بر پایه برخی فرضیات و اظهارنظرهای عمومی مدیران شرکتهای هوش مصنوعی تهیه شده، اما در عین حال به این نکته اشاره دارد که مقیاسپذیری مدلهای استدلالی نه تنها از نظر محاسباتی، بلکه بهدلیل هزینههای بالای تحقیق و توسعه نیز با چالشهایی مواجه است.

جاش یو مینویسد:

«اگر تحقیقات بهطور مداوم نیاز به هزینههای سربار داشته باشند، ممکن است مدلهای استدلالگر آنطور که انتظار میرود مقیاسپذیر نباشند. رشد سریع توان محاسباتی احتمالاً یکی از عوامل کلیدی در پیشرفت مدلهای استدلالی است، بنابراین رصد این روند اهمیت زیادی دارد.»

هرگونه نشانهای مبنی بر اینکه مدلهای استدلالگر ممکن است در آینده نزدیک به محدودیت برسند، احتمالاً نگرانیهایی را در صنعت هوش مصنوعی ایجاد خواهد کرد؛ صنعتی که تاکنون سرمایهگذاریهای عظیمی برای توسعه این مدلها انجام داده است. شایان ذکر است که برخی مطالعات نشان دادهاند مدلهای استدلالگر – که اجرای آنها بسیار پرهزینه است – دچار نواقص جدی هستند، از جمله تمایل بیشتر به تولید محتوای نادرست (hallucination) در مقایسه با برخی مدلهای معمولی.