خطرات هوش مصنوعی | تهدیدات امنیتی، شغلی و اخلاقی AI

🛑 خطرات هوش مصنوعی | نگاهی واقعبینانه به چالشهای آینده AI

🌐 مقدمه

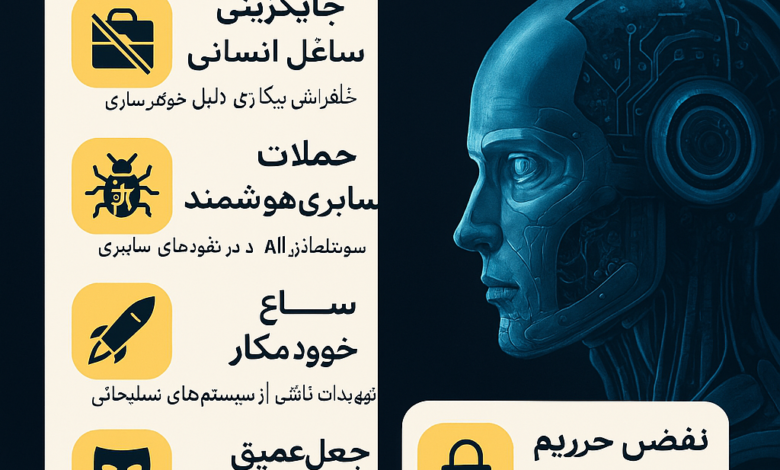

هوش مصنوعی (AI) امروز به یکی از بزرگترین دستاوردهای بشری تبدیل شده است. از خانههای هوشمند گرفته تا خودروهای خودران، از ترجمه خودکار تا تحلیلهای مالی پیچیده — همه و همه از قدرت هوش مصنوعی بهره میبرند. با این حال ، خطرات هوش مصنوعی ، پشت این پیشرفتهای درخشان، تهدیدهایی جدی پنهان شده که نمیتوان بهسادگی از آنها عبور کرد. 🤖⚠️

این مقاله قصد دارد شما را با جنبهای کمتر دیدهشده از فناوری هوش مصنوعی آشنا کند: خطرات و تهدیدهایی که ممکن است آیندهی ما را تغییر دهند. برخلاف بسیاری از مقالات که فقط روی مزایا تمرکز دارند، ما در اینجا قصد داریم با نگاهی واقعبینانه، چالشهایی مانند از بین رفتن مشاغل، تهدیدات امنیتی، مسائل اخلاقی و نقض حریم خصوصی را بررسی کنیم — و البته راهکارهایی هم برای کنترل این تهدیدها خواهیم گفت.

🧑🏭 خطرات هوش مصنوعی در اشتغالزایی و بازار کار

💼 جایگزینی نیروی انسانی با ماشینها

یکی از نخستین پیامدهای گسترده هوش مصنوعی، کاهش نیاز به نیروی کار انسانی است. با توسعه رباتها و الگوریتمهای خودکار، بسیاری از شرکتها در حال جایگزین کردن کارمندان با سیستمهای هوشمند هستند که هزینه کمتر، دقت بیشتر و کارایی بالاتری دارند. این مسئله خصوصاً در صنایع تولیدی، انبارداری، خدمات مشتری و حتی روزنامهنگاری بسیار مشهود است.

نتیجه این روند، بیکاری گسترده در برخی از حوزهها است. بسیاری از افراد به دلیل عدم تطبیق مهارتهایشان با نیازهای جدید بازار، دچار مشکلات اقتصادی میشوند. این تحولات شغلی میتوانند تبعات اجتماعی مانند افزایش فقر، نابرابری اقتصادی و حتی نارضایتیهای سیاسی در پی داشته باشند.

- کاربردهای هوش مصنوعی در خودروسازی24 تیر 1403

- تحول هوش مصنوعی: ژنتیک تا کوانتوم17 تیر 1403

- نتایج تحقیقات جدید در هوش مصنوعی23 تیر 1403

🧑💻 آسیبپذیری مشاغل تخصصی و یقهسفید

بر خلاف تصور رایج که AI فقط شغلهای ساده و تکراری را تهدید میکند، امروز شاهد آن هستیم که مشاغل تخصصی نیز در خطر هستند. ابزارهایی مانند ChatGPT، DALL·E، Copilot و Midjourney قادرند محتوا تولید کنند، کدنویسی انجام دهند، طراحی گرافیکی کنند و حتی موسیقی بسازند. 🎨🎼📜

این ابزارها باعث شدهاند که حتی حرفههایی مانند نویسندگی، طراحی، برنامهنویسی و تحلیل داده نیز با تهدید واقعی مواجه شوند. افراد باید بهجای تکرار کارهای گذشته، یاد بگیرند چگونه از این فناوریها به نفع خود استفاده کنند، در غیر اینصورت جایگزین شدن آنها توسط الگوریتمها اجتنابناپذیر است.

🧾 تبعیض در استخدام توسط الگوریتمها

بسیاری از شرکتها برای استخدام نیروی کار از الگوریتمهای هوش مصنوعی استفاده میکنند. این سیستمها رزومهها را فیلتر کرده، تحلیل میکنند و تصمیم میگیرند چه کسی برای مصاحبه مناسب است. اما اگر این الگوریتمها با دادههای ناقص یا متعصبانه آموزش دیده باشند، ممکن است ناخواسته تبعیضهایی مانند نژاد، جنسیت یا موقعیت جغرافیایی را تقویت کنند. ⚖️🚫

نمونههایی از این مشکلات در شرکتهای بزرگ مشاهده شده که سیستمهای استخدامی آنها بهصورت ناعادلانه متقاضیان زن یا افراد دارای پیشینه خاص را رد کردهاند. این نوع خطاهای الگوریتمی نهتنها بیعدالتی ایجاد میکنند، بلکه میتوانند باعث آسیب جدی به اعتبار برندها و شرکتها نیز شوند.

🛡️ تهدیدات امنیتی ناشی از هوش مصنوعی

⚔️ سوءاستفاده در جنگها و سلاحهای خودکار

یکی از ترسناکترین سناریوهای مرتبط با هوش مصنوعی، استفاده از آن در سلاحهای خودکار و سیستمهای نظامی بدون دخالت انسان است. امروزه برخی کشورها در حال توسعه پهپادها و رباتهای جنگی هستند که میتوانند بدون دخالت مستقیم انسان، هدفگیری کرده و شلیک کنند.

این نوع سلاحها، در ظاهر ممکن است دقت و سرعت بیشتری نسبت به انسانها داشته باشند، اما در صورت خطا، تصمیم اشتباه یا هک شدن سیستم، میتوانند خسارات انسانی و سیاسی جبرانناپذیری ایجاد کنند. نگرانیهای جهانی در مورد استفاده گسترده از این فناوریها، حتی موجب تشکیل کمپینهای بینالمللی برای ممنوعیت سلاحهای کشنده خودمختار شده است.

🧠 حملات سایبری هوشمند

یکی دیگر از خطرات هوش مصنوعی در حوزه امنیت سایبری نمود پیدا میکند. هکرها و مجرمان سایبری میتوانند از AI برای شناسایی آسیبپذیریها در شبکهها، رمزگشایی الگوریتمها، و طراحی حملات هدفمند استفاده کنند. 🕵️♂️💻

تصور کنید که یک سیستم هوشمند بتواند رفتار روزانه یک کارمند را تحلیل کرده و دقیقاً در زمانی که سیستم بیشترین ضعف را دارد، حمله سایبری انجام دهد. این نوع حملات میتواند اطلاعات حساس بانکی، پزشکی، یا حتی اطلاعات دولتی را به خطر بیندازد. AI در اینجا نه تنها ابزار دفاع نیست، بلکه میتواند به ابزاری برای جرایم پیشرفته دیجیتال تبدیل شود.

🎭 جعل عمیق (Deepfake) و اطلاعات نادرست

فناوری دیپفیک (Deepfake) یکی از کاربردهای نگرانکننده AI است که بهسرعت در حال گسترش است. این تکنولوژی میتواند تصاویر، ویدیوها یا صداهای کاملاً جعلی اما واقعنما از افراد مشهور، سیاستمداران یا حتی افراد عادی تولید کند. 😱🎬

در ظاهر ممکن است سرگرمکننده بهنظر برسد، اما واقعیت این است که دیپفیک میتواند برای انتشار اخبار دروغ، بیاعتبارسازی افراد، یا حتی دستکاری نتایج انتخابات مورد استفاده قرار گیرد. تشخیص واقعیت از جعل در عصر AI بهمراتب سختتر شده و میتواند تأثیرات اجتماعی، سیاسی و فرهنگی عمیقی به دنبال داشته باشد.

⚖️ چالشهای اخلاقی در استفاده از هوش مصنوعی

❓ نبود شفافیت در تصمیمگیریهای AI

یکی از اساسیترین مشکلات سیستمهای هوش مصنوعی، عدم شفافیت در فرآیند تصمیمگیری آنها است. بسیاری از الگوریتمهای پیشرفته بهقدری پیچیده هستند که حتی توسعهدهندگان آنها نیز نمیدانند دقیقاً چرا یک نتیجه خاص تولید شده است. به این پدیده جعبه سیاه (Black Box) میگویند.

این موضوع زمانی بحرانی میشود که تصمیمگیری AI بر سرنوشت افراد تأثیرگذار باشد؛ مانند تعیین اعتبار بانکی، تشخیص بیماری، یا حتی صدور حکم قضایی. اگر کسی نتواند تصمیم AI را توضیح دهد، چگونه میتوان آن را مورد اعتراض قرار داد یا اصلاح کرد؟ این مسئله بهوضوح با اصول عدالت و شفافیت در تضاد است.

🧯 مسئولیتپذیری در خطاهای سیستمی

اگر یک ماشین خودران با استفاده از هوش مصنوعی، تصادف مرگبار کند — چه کسی مسئول است؟ تولیدکننده خودرو؟ برنامهنویس الگوریتم؟ یا خود ماشین؟ این سؤال ساده نیست و هنوز پاسخ قطعی ندارد. ⚠️🚗

مسئله مسئولیتپذیری در خطاهای AI یکی از مهمترین چالشهای حقوقی و اخلاقی عصر جدید است. چون برخلاف انسان، AI وجدان یا درک انسانی ندارد و نمیتوان آن را مجازات کرد یا به دادگاه کشید. بنابراین، تا زمانی که قوانین مشخص و بهروزی در این زمینه تدوین نشود، نمیتوان از AI در حوزههایی مانند سلامت، قضاوت یا امنیت عمومی بهصورت گسترده استفاده کرد.

👥 الگوریتمهای ناعادلانه و تبعیضآمیز

الگوریتمهای AI بهظاهر بیطرف هستند، اما اگر با دادههای نادرست یا متعصبانه آموزش ببینند، میتوانند همان تبعیضهای انسانی را تقویت کنند. مثلاً اگر در دادههای آموزشی یک سیستم شناسایی چهره، تصاویر افراد با پوست روشن بیشتر باشد، دقت آن برای تشخیص چهرههای تیره کمتر خواهد بود.

نمونههایی از این مشکل قبلاً در سیستمهای تشخیص چهره پلیسها، سامانههای استخدام هوشمند و حتی پلتفرمهای وامدهی بانکی دیده شده است. اگر این چالشها جدی گرفته نشوند، میتوانند به تقویت نابرابری و بیعدالتی اجتماعی منجر شوند.

🔒 نقض حریم خصوصی با فناوریهای هوشمند

📱 ردیابی رفتاری و شنود دیجیتال

اپلیکیشنها، دستیارهای صوتی و دستگاههای هوشمند، همیشه در حال جمعآوری اطلاعات کاربران هستند. بسیاری از این اطلاعات بدون آگاهی کامل کاربر ذخیره و تحلیل میشوند. آیا تا به حال احساس کردهاید درباره موضوعی فقط صحبت کردهاید و لحظاتی بعد، تبلیغ آن را در اینستاگرام یا گوگل دیدهاید؟ این یک تصادف نیست؛ این AI در حال تحلیل مکالمات و رفتارهای شماست. 😶🌫️

این نوع از نقض حریم خصوصی اگرچه در چارچوب قوانین برخی کشورها انجام میشود، اما در بسیاری موارد بدون رضایت شفاف کاربر است. اگر کنترل این جمعآوریها انجام نشود، ممکن است در آینده شاهد سوءاستفادههای گستردهای از اطلاعات شخصی باشیم.

💾 جمعآوری بیاجازه دادهها توسط اپلیکیشنها

بسیاری از اپلیکیشنها و وبسایتها، بهصورت پیشفرض دادههایی مانند موقعیت مکانی، سابقه جستجو، مخاطبین، و حتی مکالمات صوتی را ذخیره میکنند. این دادهها برای بهبود عملکرد الگوریتمهای هوش مصنوعی استفاده میشوند — اما اغلب کاربران از این موضوع مطلع نیستند.

مشکل اینجاست که این دادهها ممکن است به شرکتهای تبلیغاتی، مؤسسات تحقیقاتی یا حتی دولتها فروخته شوند. در دنیای امروز، دادهها ارزشمندترین دارایی دیجیتال هستند و در صورتی که قوانین دقیق و روشنی برای استفاده از آنها تدوین نشود، کاربران عادی تبدیل به «منبع استخراج اطلاعات» میشوند.

🏪 فروش اطلاعات کاربران به شرکتهای ثالث

بسیاری از شرکتهای بزرگ فناوری، دادههای کاربران را به شرکتهای تبلیغاتی یا تجاری دیگر میفروشند تا سود بیشتری کسب کنند. این تجارت داده که به اقتصاد نظارتی (Surveillance Capitalism) مشهور است، یکی از مهمترین خطرات پنهان در پشت پرده هوش مصنوعی است.

در این حالت، کاربران بدون آنکه بدانند یا رضایت داده باشند، به بخشی از زنجیره تجاری شرکتها تبدیل میشوند. این موضوع میتواند به از بین رفتن اعتماد عمومی نسبت به فناوری منجر شود — و مهمتر از آن، احساس ناامنی دائم در فضای دیجیتال.

🧠 سناریوهای خطرناک در آینده هوش مصنوعی

🔓 از کنترل خارج شدن سیستمهای پیشرفته

یکی از نگرانیهای جدی در مورد AI، این است که در آیندهای نهچندان دور، برخی از سیستمهای پیشرفته میتوانند از کنترل انسان خارج شوند. تصور کنید یک سیستم دفاعی خودکار که بهاشتباه تشخیص دهد تحت حمله است و بدون تأیید انسانی اقدام به پاسخ دهد!

این خطرات تنها در فیلمهای علمیتخیلی نیستند. کارشناسان بزرگی مانند ایلان ماسک، بیل گیتس و استفان هاوکینگ هشدار دادهاند که اگر نظارت و محدودیتهای اخلاقی و قانونی کافی اعمال نشود، AI میتواند به تهدیدی برای بشریت تبدیل شود. 🚨

🧬 احتمال شکلگیری آگاهی مصنوعی

در حال حاضر، هوش مصنوعی دارای آگاهی نیست، اما برخی دانشمندان معتقدند اگر توسعه آن بدون محدودیت ادامه یابد، ممکن است روزی AI نوعی آگاهی پیدا کند یا به هوش مصنوعی عمومی (AGI) برسد.

در این حالت، AI میتواند تصمیماتی بگیرد که در تضاد با منافع انسانی باشد. اگر این سیستمها اولویت خود را حفظ بقا یا دستیابی به اهداف خود بدانند، ممکن است انسان را بهعنوان مانع تلقی کنند — سناریویی که در بسیاری از فیلمها مانند Terminator یا Ex Machina به تصویر کشیده شده است. 🎥🤖

🧠 سلطه الگوریتمها بر تصمیمگیریهای انسانی

حتی بدون آگاهی یا کنترل مستقیم، AI میتواند بهمرور بر تمامی جنبههای زندگی انسانی مسلط شود. الگوریتمهایی که پیشنهاد خرید، انتخاب فیلم، مسیر رانندگی، و حتی تصمیمات پزشکی میدهند، ممکن است بهجای انسان تصمیم بگیرند.

در چنین شرایطی، انسانها استقلال خود را از دست میدهند و تبدیل به اجراکنندگان تصمیمات الگوریتمی میشوند. این سلطه نامرئی، اگرچه آرام و بیسر و صداست، اما میتواند یکی از خطرناکترین سناریوهای آینده تکنولوژی باشد.

📚 مطالعه بیشتر در AI خبر

برای آشنایی بیشتر با خطرات، فرصتها و آینده هوش مصنوعی، پیشنهاد میکنیم حتماً از دو بخش زیر در سایت AI خبر بازدید کنید:

💡 دستهبندی «هوش مصنوعی»

در این بخش، مقالاتی درباره مفاهیم پایه، کاربردهای روزمره، تهدیدات و سیاستگذاریهای جهانی در حوزه AI منتشر میشود. مناسب برای علاقهمندان، دانشجویان و تحلیلگران.

🔮 دستهبندی «تکنولوژیهای آینده»

اگر به آینده تکنولوژی، رباتها، اینترنت اشیا، و نقش AI در زندگی آینده علاقهمند هستید، این بخش را از دست ندهید. مقالههای این دستهبندی به زبان ساده و همراه با تحلیل تخصصی منتشر میشوند.